¿Qué modelo de OpenAI deberías usar? (agosto 2025)

Hasta agosto en ChatGPT se podía elegir el modelo de LLM y lo normal era preguntarse: ¿cuál es el mejor para mí? Pero eso ya no es necesario.

Algunos factores de los que dependía la elección son: velocidad, coste, calidad, privacidad… Cada modelo estaba diseñado para un tipo de tarea diferente pero ahora se ha unificado todo en GPT-5.

Y además está el modelo gpt-oss (modelo open-source) para ejecutar en local. Todo lo demás se ha incorporado en GPT-5.

GPT-5 (el modelo que decide por ti que modelo usar)

GPT-5 es el modelo de inteligencia artificial más reciente desarrollado por OpenAI, lanzado el 7 de agosto de 2025. Se trata de un sistema de lenguaje grande (Large Language Model o LLM) que representa una evolución significativa respecto a sus predecesores como GPT-4, enfocándose en ser más inteligente, rápido y útil para una variedad de tareas. Entre sus características destacadas se incluyen un contexto de hasta 400.000 tokens (lo que permite manejar conversaciones o documentos más extensos), mejoras en razonamiento profundo, codificación y tareas «agenticas» (como la ejecución autónoma de acciones). Está disponible tanto para usuarios gratuitos de ChatGPT (con límites de uso) como para suscriptores pagos, y se integra en la API de OpenAI para desarrolladores.

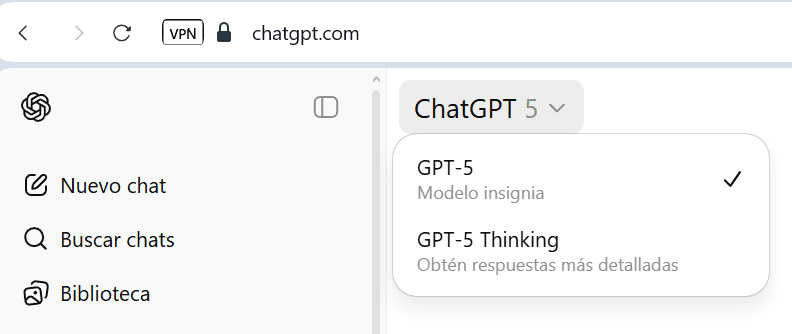

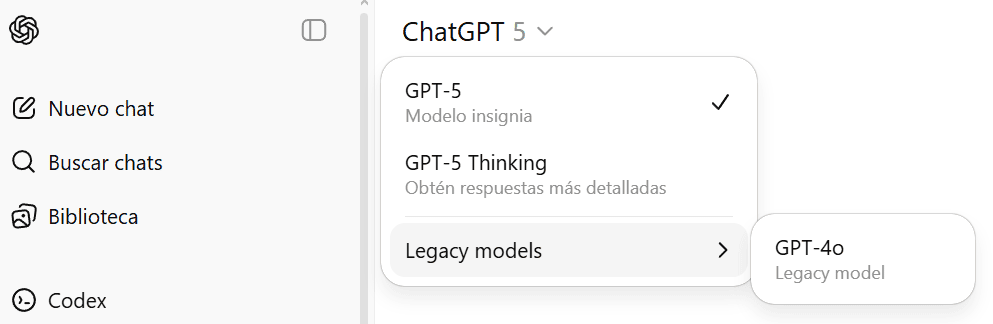

Con la aparición de GPT-5 ha desaparecido la elección de modelo a usar y se ha unificado todo en los modelos GPT-5 y GPT-5 Thinking:

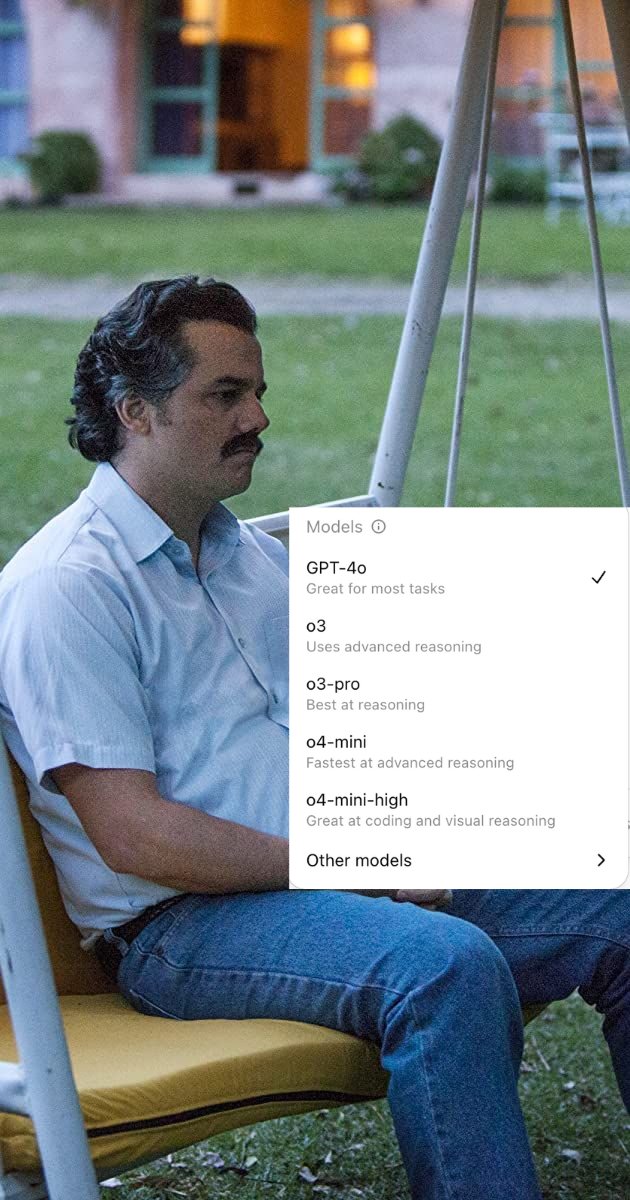

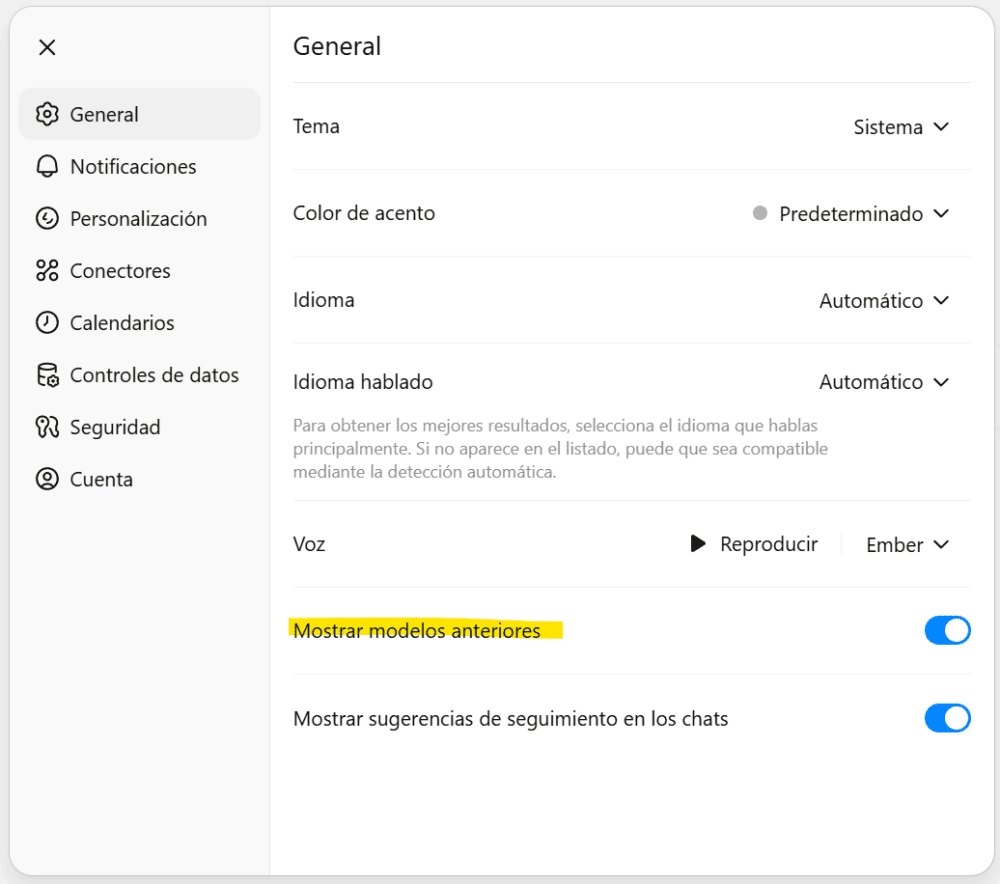

Aunque se pueden activar los modelos anteriores y entonces está disponible el GPT-4o:

El modelo evalúa automáticamente la complejidad de la consulta o prompt del usuario para seleccionar entre sus modos internos:

- Modo Chat (rápido): Para respuestas inmediatas y conversaciones generales, priorizando velocidad y eficiencia.

- Modo Thinking (razonamiento profundo): Para tareas complejas que requieren análisis detallado, donde aplica un razonamiento paso a paso visible para el usuario.

Esta decisión se basa en factores como el contenido del prompt, señales de la conversación (por ejemplo, si es una pregunta simple o un problema matemático avanzado), patrones aprendidos de preferencias del usuario y métricas de precisión del modelo. Si detecta que la tarea es exigente, switches automáticamente al modo Thinking.

Por ejemplo, si preguntas algo sencillo como «cuéntame un chiste», usará el modo Chat para una respuesta rápida. Pero si pides resolver un problema de programación avanzado, activará el modo Thinking para mostrar el proceso de razonamiento y llegar a una solución más precisa.

GPT-4o (modelo legacy)

GPT-4o es un modelo de inteligencia artificial multimodal desarrollado por OpenAI, lanzado el 13 de mayo de 2024. El «o» en su nombre significa «omni», lo que refleja su capacidad para procesar y generar contenido en múltiples modalidades: texto, audio, imágenes y video. A diferencia de modelos anteriores como GPT-4, que requerían sistemas separados para manejar diferentes tipos de entrada (por ejemplo, transcripción de audio a texto y luego procesamiento), GPT-4o está entrenado de extremo a extremo en una sola red neuronal, lo que permite una integración más fluida y eficiente entre modalidades.

Principales características y capacidades:

- Multimodalidad: Acepta combinaciones de entradas como texto, audio, imágenes y video, y genera salidas en texto, audio o imágenes. Por ejemplo, puede describir imágenes, responder a consultas visuales, procesar audio en tiempo real (incluyendo detección de tono emocional, múltiples hablantes o ruidos de fondo) y generar voz con emociones, risas o incluso canto.

- Velocidad y eficiencia: Responde a entradas de audio en tan solo 232 milisegundos (promedio de 320 ms), similar al tiempo de respuesta humano en conversaciones. Es un 50% más barato y más rápido que GPT-4 Turbo en la API, con límites de tasa 5 veces mayores.

- Rendimiento: Igual a GPT-4 Turbo en texto en inglés, razonamiento y codificación, pero con mejoras significativas en idiomas no ingleses (reduce tokens en lenguajes como gujarati en 4.4x o telugu en 3.5x), visión y audio. Establece nuevos estándares en comprensión multilingüe y multimodal.

- Modo de voz: En ChatGPT, incluye un nuevo Voice Mode que permite conversaciones en tiempo real con interrupciones, comprensión emocional y respuestas más naturales, superando las latencias de versiones anteriores (2.8-5.4 segundos).

- Ventana de contexto: Soporta hasta 128.000 tokens, lo que permite manejar conversaciones o documentos extensos.

gpt-oss (modelo open-source)

gpt-oss se ejecuta en tu portátil o móvil. Ideal para uso privado, herramientas offline y desarrollo personalizado.

Perfecto para:

- Crear un chatbot local

- Usar IA sin conexión a internet

- Redactar notas o documentos offline

- Crear un asistente por voz

- Desarrolladores que prueban IA en local