¿Cuáles son las fuentes de datos para entrenar GPT-4?

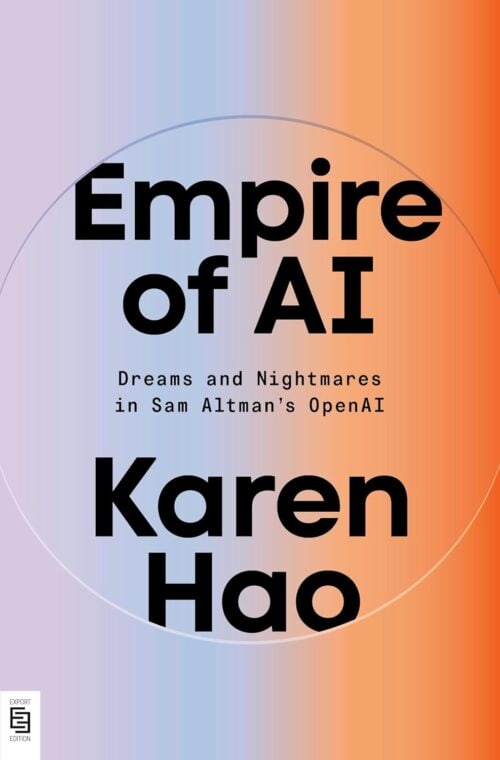

Gracias a la excelente investigación de Karen Hao para su libro «Empire of AI«, por fin tenemos un desglose de los datos usados por OpenAI.

¿De dónde vienen los datos con los que se entrena GPT-4?

Para responder esta pregunta es esencial referirse a la investigación realizada por la periodista Karen Hao, quien basó sus hallazgos en entrevistas directas con más de 90 empleados actuales y anteriores de OpenAI. Gracias a esta investigación conocemos detalles importantes sobre la evolución en la recopilación y gestión de datos en los distintos modelos GPT.

GPT-2

El punto de partida para entender el entrenamiento de GPT-4 es remontarnos a 2019, cuando Alec Radford desarrolló GPT-2. Radford optó por ser muy selectivo en cuanto a los datos utilizados: recopiló mediante scraping todos los enlaces externos publicados en Reddit que contaban con tres o más puntos de karma. Así nació WebText, un conjunto de 8 millones de páginas web que ocupaba «tan solo» 40 GB.

Curiosamente, aunque GPT-2 era más pequeño en número de parámetros y volumen de datos comparado con sus sucesores, destacó por la alta calidad de sus datos. Posteriormente, para escalar hacia modelos como GPT-3 y GPT-4, OpenAI debió sacrificar calidad en favor de cantidad, reduciendo progresivamente la calidad media de los datos utilizados.

En términos comparativos, GPT-2 contaba con 1.500 millones de parámetros, mientras que GPT-3 dio un enorme salto hasta los 175.000 millones. Este incremento exigió un volumen proporcional de datos para evitar que el modelo simplemente replicara frases palabra por palabra de sus datos de entrenamiento.

GPT-3

Por ello, en 2020, un equipo liderado por Dario Amodei, actual CEO de Anthropic, amplió considerablemente la base de datos utilizada por GPT-3 incluyendo:

- Toda la Wikipedia en inglés.

- Más enlaces procedentes de Reddit, ahora con menos requisitos de karma.

- Una versión cuidadosamente filtrada de Common Crawl, seleccionando las páginas web que más se parecían estructuralmente a artículos de Wikipedia.

- Un polémico conjunto de datos denominado Books2, que según las fuentes entrevistadas por Karen Hao, incluía Library Genesis, una biblioteca pirata con libros protegidos por derechos de autor y sin autorización de sus autores.

Tras las críticas recibidas, OpenAI reconoció el uso de Books2 y afirmó haberlo eliminado en las versiones posteriores a GPT-3.5, por lo que ChatGPT no incluiría esos datos.

GPT-4

Volviendo a Common Crawl, cabe mencionar que Radford inicialmente rechazó este archivo gratuito de internet por su baja calidad. Sin embargo, para GPT-4, la necesidad de datos era tal que en 2022 se decidió incorporar prácticamente la totalidad de Common Crawl sin realizar filtrados exhaustivos de calidad.

Y no solo eso: para entrenar GPT-4 se incluyeron además:

- Una descarga completa de GitHub proporcionada por Microsoft.

- Enlaces y contenido extraído de Twitter.

- Transcripciones automáticas de vídeos alojados en YouTube.

- Otros repositorios de datos accesibles en internet, como Pastebin.

En esencia, cualquier contenido online que no tuviese explícitamente protegida su recopilación fue considerado apto para alimentar el entrenamiento de GPT-4.

De la calidad estricta al todo vale

Este cambio de enfoque desde la calidad estricta en GPT-2 al «todo vale» en GPT-4 tuvo importantes consecuencias.

Del foco en la calidad en GPT-2 se pasó al «todo vale» para GPT-4.

Hasta GPT-2, OpenAI controlaba cuidadosamente los datos de entrada, pero desde GPT-3 el foco cambió hacia la moderación de los resultados, incorporando supervisión humana intensiva a través de técnicas como el Reinforcement Learning from Human Feedback (RLHF). Aunque esto resolvió en parte el problema de calidad y seguridad en las respuestas del modelo, simultáneamente creó otro: se volvió prácticamente imposible bloquear por completo todos los resultados no deseados. De hecho, esto ha llevado al surgimiento de técnicas como el jailbreaking, que consiguen revelar respuestas inapropiadas o no deseadas, originalmente destinadas a permanecer ocultas.

Este cambio de estrategia refleja un compromiso complejo: para que los modelos actuales sean capaces de manejar la enorme escala demandada, OpenAI optó por sacrificar parcialmente el control estricto sobre los datos utilizados, confiando en posteriores técnicas humanas para mitigar las consecuencias negativas de esta decisión.

En definitiva, cualquier cosa online que no tuviera una protección o advertencia explícita contra su escrapeo fue tratada como «aceptable» para alimentar a GPT-4. Del foco en la calidad en GPT-2 se pasó al «todo vale» para GPT-4.

P.D. El libro es recomendable 100%. Si no lo tenéis, ya tardáis en comprarlo.

Información basada en la publicación de Juan González Villa (Consultor SEO y divulgador sobre IA) en Twitter el 12 de julio de 2025.