La era Copilot («the age of copilots»)

Parece mentira que sólo haya pasado un año desde que ChatGPT vio la luz. Hemos hecho mucho desde entonces y el ritmo de la innovación ha sido asombroso.

Aquí os dejo un resumen (en castellano) del discurso de Satya Nadella (Chairman and CEO at Microsoft) en Microsoft Ignite del 16 de noviembre de 2023.

La era de los copilotos

Parece mentira que sólo haya pasado un año desde que ChatGPT vio la luz por primera vez. Hemos hecho mucho desde entonces y el ritmo de la innovación ha sido asombroso.

Es emocionante entrar en una nueva fase de la IA en la que no sólo hablamos de innovación en abstracto, sino de fabricación de productos, despliegue, seguridad de la IA y aumento real de la productividad. Estamos en un punto de inflexión. Esta es claramente la era de los copilotos.

Y, hoy, hemos compartido nuevos datos que muestran las ganancias reales de productividad que Microsoft Copilot ya está impulsando. Estamos adoptando una perspectiva muy amplia para comprender en profundidad el impacto de Copilot tanto en la creatividad como en la productividad. Y los resultados son bastante sorprendentes: Con Copilot, puedes completar las tareas mucho más rápido, y eso está teniendo un efecto cascada en el trabajo y el flujo de trabajo en todas partes.

Creemos que Copilot será la nueva interfaz de usuario que le ayudará a acceder al conocimiento del mundo y de tu organización, pero lo más importante es que será el agente que le ayudará a actuar sobre ese conocimiento.

Por eso, esta semana en Ignite, presentamos 100 nuevas actualizaciones en cada capa de la plataforma, para ayudarnos a hacer realidad esa visión.

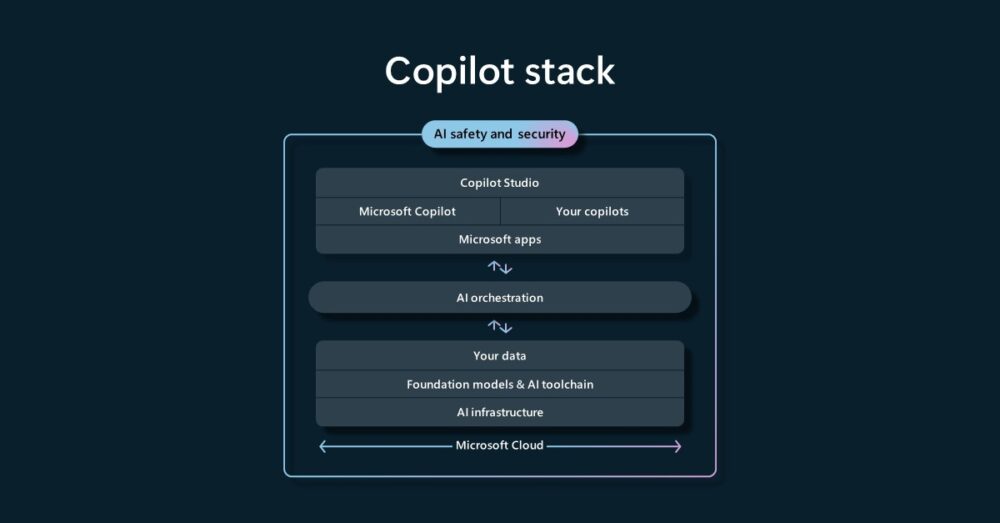

Nuestra plataforma Copilot integral para cada organización abarca la infraestructura, los modelos básicos, las cadenas de herramientas, los datos y, por supuesto, el propio Copilot:

Y, hoy, he destacado cinco temas clave en todo lo que estamos anunciando.

Infraestructura de IA

Comienza con la capa de infraestructura de IA y nuestro enfoque de Azure como el ordenador del mundo. Ofrecemos la infraestructura global más completa con más de 60 regiones de centros de datos, más que cualquier otro proveedor.

Ser el ordenador del mundo significa que también tenemos que ser la mejor empresa de sistemas del mundo en infraestructuras heterogéneas.

Trabajamos estrechamente con nuestros socios en todo el sector para incorporar la mejor innovación desde la energía, al centro de datos, al rack, a la red, al cómputo central, así como a los aceleradores de IA. Y, en esta nueva era de la IA, estamos redefiniendo todo en toda nuestra gama.

A medida que construimos nuestros centros de datos, trabajamos para abastecernos de energía renovable. De hecho, hoy somos uno de los mayores compradores de energía renovable del mundo. Hemos obtenido más de 19 gigavatios de energía renovable desde 2013.

Y estamos trabajando con productores para traer nueva energía eólica, solar, geotérmica y de fusión nuclear. Y me ha entusiasmado compartir que estamos en vías de cumplir nuestro objetivo de generar el 100% de la energía que utilizamos en nuestros centros de datos a partir de fuentes con cero emisiones de carbono para 2025.

Hoy también me ha encantado anunciar la disponibilidad general de Azure Boost. Ha sido fantástico hablar de este nuevo sistema que descarga los procesos de virtualización de servidores en software y hardware específicamente diseñados. Esto permite mejoras masivas en las redes, así como en el rendimiento del almacenamiento remoto y local, lo que convierte a Azure en la mejor nube para cargas de trabajo de alto rendimiento, al tiempo que refuerza la seguridad.

También aprovechamos la innovación de todo el sector, incluidos nuestros socios AMD e Intel, y la ponemos a su disposición.

Como hiperescalador, vemos las cargas de trabajo, aprendemos de ellas y tenemos la oportunidad de optimizar toda la plataforma, desde el consumo de energía hasta el silicio, para maximizar el rendimiento y la eficiencia. Gracias a este ciclo de retroalimentación, estoy encantado de presentar nuestra primera serie de CPU internas personalizadas, Azure Cobalt, empezando por Cobalt 100.

Cobalt es la primera CPU diseñada por nosotros específicamente para la nube de Microsoft. Este chip de 64 bits y 128 núcleos basado en ARM es el más rápido de cualquier proveedor de la nube. Ya está alimentando partes de Microsoft Teams, Azure Communications Services, así como Azure SQL.

En lo que respecta a los aceleradores de IA, también nos estamos asociando ampliamente con toda la industria para hacer de Azure la mejor nube, sin preguntas, tanto para la formación como para la inferencia.

Todo comienza con nuestra estrecha colaboración con Nvidia. Hemos creado la infraestructura de supercomputación de IA más potente de la nube utilizando GPU de Nvidia.

De hecho, la semana pasada, Azure fue la que más GPUs presentó al MLPerf Benchmarking Consortium, con 10.000 GPUs H100, tres veces más que el récord anterior, ofreciendo mejor rendimiento que cualquier otra nube. Y, en la lista Top500 de los superordenadores del mundo, Azure fue el superordenador más potente de la nube pública, y el tercero, en total.

A medida que construimos superordenadores para entrenar estos grandes modelos, InfiniBand nos proporciona una ventaja única. Y hoy hemos ido aún más lejos. Anunciamos que añadiríamos a nuestra flota el último acelerador de IA de GPU de Nvidia, H200, para soportar instancias de modelos aún mayores con la misma latencia.

También presentamos el primer avance de Azure Confidential GPU VMs, para que puedas ejecutar tus modelos de IA en conjuntos de datos sensibles en nuestra nube. Lo hemos diseñado conjuntamente con Nvidia.

También me entusiasmó anunciar que el emblemático acelerador de IA MI300X de AMD llega a Azure para ofrecerte aún más opciones de máquinas virtuales optimizadas para IA. Una vez más, esto significa que podemos servir grandes modelos más rápidamente. Ya hemos puesto en marcha GPT-4 en MI300X y hoy hemos ofrecido acceso anticipado a clientes seleccionados.

Y no nos detendremos ahí. Nos hemos comprometido a aprovechar todo nuestro saber hacer en todos los sistemas y a ofrecerles las mejores innovaciones de nuestros socios y de nosotros mismos.

Por eso, hoy también hemos anunciado nuestro primer acelerador de IA totalmente personalizado Azure Maia, diseñado para ejecutar cargas de trabajo de IA en la nube, como el entrenamiento y la inferencia LLM. Este chip se fabrica en un proceso de 5 nanómetros y cuenta con 105.000 millones de transistores, lo que lo convierte en uno de los mayores chips que pueden fabricarse con la tecnología actual:

Pero va más allá del chip. Hemos diseñado Maia para la IA. Las demandas de potencia de la IA exigen una infraestructura radicalmente distinta a la de otras nubes. Las cargas de trabajo de computación requieren mucha más refrigeración, así como densidad de red. Hemos diseñado la unidad de refrigeración para que se adapte al perfil térmico del chip y hemos añadido refrigeración líquida de circuito cerrado a nivel de bastidor para aumentar la eficiencia.

Esta arquitectura nos permite instalar este rack en infraestructuras e instalaciones de centros de datos ya existentes en lugar de construir otros nuevos. Ya lo estamos probando con muchos de nuestros servicios de IA, como GitHub Copilot. Y desplegaremos los aceleradores Maya en toda nuestra gama, primero para nuestras propias cargas de trabajo, y después para cargas de trabajo de terceros.

Esta diversidad de silicio es lo que nos permite impulsar los modelos básicos más potentes del mundo y todas nuestras cargas de trabajo de IA.

Modelos básicos y cadena de herramientas de IA

Pasemos ahora a la siguiente capa de la plataforma: los modelos básicos que sólo son posibles gracias a estos sistemas avanzados de los que he hablado.

Los modelos generativos de IA abarcan desde billones de parámetros para LLM que requieren las GPU más potentes de Azure, hasta unos pocos miles de millones de parámetros, modelos de lenguaje pequeños específicos de tareas, o SLM. Y ofrecemos la mejor selección de modelos que puede utilizar para crear sus propias aplicaciones de IA, al tiempo que satisface sus necesidades específicas de coste, latencia y rendimiento.

Todo comienza con nuestra estrecha colaboración con OpenAI. Están realizando un trabajo revolucionario para avanzar en el estado de los modelos de IA, y estamos encantados de participar juntos en esta asociación.

Y nuestra promesa a nuestros clientes es sencilla: A medida que OpenAI innove, ofreceremos toda esa innovación como parte de Azure AI. Es por eso que estamos trayendo los últimos modelos de OpenAI, incluyendo GPT-4 Turbo, y GPT-4 Turbo con Vision, a nuestro servicio Azure OpenAI.

GPT-4 Turbo ofrece precios más bajos, formato JSON estructurado y avisos ampliados. Estará disponible en el servicio Azure OpenAI esta semana, y el precio de los tokens para estos nuevos modelos estará a la par con OpenAI.

También estamos totalmente comprometidos con el código abierto, y queremos traer la mejor selección de modelos de código abierto a Azure y hacerlo de forma responsable. Nuestro catálogo de modelos ya cuenta con la más amplia selección de modelos, y estamos añadiendo aún más a nuestro catálogo.

Y, hoy, hemos dado un gran paso más en apoyo de los modelos de código abierto, añadiendo una oferta de modelos como servicio en Azure. Esto te permitirá acceder a estos modelos de gran tamaño sin tener que aprovisionar GPU para que puedas centrarte en el desarrollo, no en las operaciones de backend.

Estamos orgullosos de colaborar con Meta en este proyecto. Puedes ajustar Llama 2 con tus datos para que el modelo comprenda mejor tu dominio y genere predicciones más precisas. También queremos ofrecer modelos en todos los idiomas y en todos los países. Y nos hemos asociado con Mistral para ofrecer sus modelos premium como servicio, así como con Group 42 para ofrecer Jais, el modelo árabe de mayor calidad del mundo, también como servicio.

Ahora, cuando hablamos de código abierto, hay otra cosa muy emocionante que está sucediendo en este espacio y son los SLM. Nos encantan los SLM. De hecho, uno de los mejores es Phi, un modelo construido por Microsoft Research sobre conjuntos de datos altamente especializados, que puede rivalizar con modelos 50 veces mayores.

De hecho, Phi 1.5 sólo tiene 1.300 millones de parámetros, pero aun así demuestra un rendimiento puntero en pruebas comparativas que evalúan aspectos como el sentido común, la comprensión del lenguaje y el razonamiento lógico.

Y hoy, me ha encantado anunciar Phi 2, una versión ampliada de Phi 1.5 que muestra capacidades aún mejores en todas estas pruebas, sin dejar de ser relativamente pequeña, con 2.700 millones de parámetros. Phi 2 es de código abierto y pronto estará disponible en nuestro catálogo.

Una vez que tenga estos modelos, lo siguiente son las herramientas. Con Azure AI Studio, ofrecemos toda la cadena de herramientas del ciclo de vida para que pueda crear, personalizar, entrenar, evaluar y desplegar los últimos modelos de nueva generación. También incluye herramientas de seguridad integradas.

La otra cosa que estamos haciendo con Azure AI Studio es ampliarlo a cualquier endpoint, empezando por Windows. Puede personalizar SLM de última generación y aprovechar nuestras plantillas para escenarios de desarrollo comunes, de modo que pueda integrar estos modelos directamente en sus aplicaciones.

Antes he mencionado nuestra colaboración con Nvidia. Juntos, estamos innovando para hacer de Azure la mejor nube para la formación y la inferencia. Nuestra colaboración se extiende a toda la plataforma, incluidas nuestras mejores soluciones para el desarrollo de IA. Y, en Ignite, anunciamos una expansión de nuestra asociación para llevar el Generative AI Foundry Service de Nvidia a Azure.

El fundador, presidente y CEO de Nvidia, Jensen Huang, se unió a mí para hablar de nuestra colaboración. Esta es nuestra conversación:

Tus datos

Ahora, hablemos de los datos, que es quizás la consideración más importante, porque en cierto sentido, no hay IA sin datos.

Microsoft Fabric reúne todos tus datos, así como tus cargas de trabajo analíticas, en una experiencia unificada. Fabric ha sido nuestro mayor lanzamiento de datos desde SQL Server, y la recepción de la vista previa ha sido increíble.

Y hoy, estoy encantado de anunciar la disponibilidad general de Microsoft Fabric:

También anunciamos una nueva capacidad que llamamos mirroring. Se trata de una forma sencilla de añadir almacenes de datos en la nube, así como bases de datos a Fabric, desde Cosmos DB o Azure SQL DB, así como desde Mongo DB y Snowflake, no solo en nuestra nube, sino en cualquier nube.

Microsoft Teams

Ahora, subamos por la plataforma y hablemos de cómo estamos reimaginando todas nuestras aplicaciones principales en esta era de la IA, incluido Teams.

Nuestra visión para Teams siempre ha sido reunir todo lo que necesitas en un solo lugar a través de la colaboración, el chat, las reuniones y las llamadas. Más de 320 millones de personas confían en Teams para mantenerse productivas y conectadas.

El mes pasado lanzamos el nuevo Teams, que hemos reimaginado para esta nueva era de la IA. El nuevo Teams es hasta dos veces más rápido, utiliza un 50 por ciento menos de recursos y puede ahorrarte tiempo y ayudarte a colaborar de forma mucho más eficiente. También hemos simplificado la experiencia del usuario. Es más fácil hacer más cosas con menos clics. También es la base de la próxima generación de experiencias basadas en IA, que transformarán nuestra forma de trabajar. Y está disponible tanto en Windows como en Mac y, por supuesto, en todos los terminales telefónicos.

Pero Teams es más que una herramienta de comunicación y colaboración. También es un lienzo multijugador que reúne procesos empresariales directamente en el flujo de tu trabajo. En la actualidad, más de 2.000 aplicaciones forman parte de la tienda de Teams. Las aplicaciones de Adobe, Atlassian, ServiceNow y Workday tienen más de un millón de usuarios activos mensuales. Y empresas de todos los sectores han creado 145.000 aplicaciones de línea de negocio personalizadas en Teams.

Y cuando pensamos en Teams, es importante basarnos en que la presencia es, de hecho, la killer application definitiva. Y eso es lo que nos motiva a llevar el poder de Mesh a Teams, reimaginando la forma en que los empleados se reúnen y se conectan utilizando cualquier dispositivo, ya sea un PC, HoloLens o Meta Quest. Me ha emocionado compartir que Mesh estará disponible de forma general en enero.

Microsoft Copilot

Pasemos ahora a la cima de la plataforma, Microsoft Copilot.

Nuestra visión es sencilla: Somos la empresa del copiloto. Creemos en un futuro en el que habrá un copiloto para todo lo que hagas. Microsoft Copilot es esa experiencia única que se ejecuta en todas nuestras superficies, comprendiendo tu contexto en la Web y en tu dispositivo. Y cuando estás en el trabajo, te ofrece las habilidades adecuadas cuando las necesitas.

Empieza con la búsqueda, que está integrada en Copilot y te acerca el contexto de la Web. La búsqueda, tal y como la conocemos, está cambiando, y nosotros nos sumamos a ella. Bing Chat es ahora Copilot. Es un destino independiente y funciona estés donde estés, en Microsoft Edge, en Google Chrome, en Safari, así como en móviles, próximamente.

Nuestra versión Enterprise, que añade protección de datos comerciales, también es ahora Copilot. Solo tienes que iniciar sesión con tu Entra ID de Microsoft para acceder a ella. Estará disponible sin coste adicional para todos los usuarios de Entra ID que cumplan los requisitos.

Y, hace apenas dos semanas, anunciamos la disponibilidad general de Copilot para Microsoft 365. Puede razonar en todo Microsoft Graph. Además, integra Copilot en tus aplicaciones favoritas, ya sea Teams, Outlook, Excel, etc., y viene con complementos para todo el conocimiento y las acciones empresariales disponibles en Graph.

Cuando se trata de ampliar Copilot, hoy admitimos plug-ins, y también estamos muy entusiasmados con lo que OpenAI anunció la semana pasada con GPTs. Los GPT son una nueva forma de crear una versión personalizada de ChatGPT que resulte más útil para tareas muy específicas en el trabajo o en casa. A partir de ahora, podrás utilizar tanto plug-ins como GPTs en Copilot para adaptar tu experiencia.

Por supuesto, tendrás que adaptar Copilot a tus necesidades específicas, tus datos, tus flujos de trabajo y tus requisitos de seguridad. No hay dos procesos empresariales ni dos empresas iguales. Por eso hoy hemos anunciado Copilot Studio:

Ya estamos utilizando este patrón para ampliar Copilot para cada rol y función.

Para los desarrolladores, GitHub Copilot está convirtiendo el lenguaje natural en lenguaje de programación, ayudándoles a codificar un 55% más rápido.

Para los equipos de operaciones de seguridad, Copilot les ayuda a responder a las amenazas a la velocidad de la máquina. De hecho, esta semana añadimos complementos para la gestión de identidades, la seguridad de puntos finales y también para los gestores de riesgos y cumplimiento normativo.

Para los comerciales, Copilot está ahí, ayudándoles a cerrar más contratos. Tanto si estás respondiendo por correo electrónico como en una reunión de Teams, puedes enriquecer esa interacción con el cliente conectando Copilot con tus datos de CRM, ya sea en Salesforce o Dynamics 365.

Y, para los equipos de atención al cliente, hoy hemos anunciado Copilot for Service para ayudar a los agentes a resolver los casos más rápidamente. Proporciona a los agentes acceso a los conocimientos y el contexto adecuados dentro de las herramientas que utilizan a diario, y también puede integrarse directamente en las aplicaciones de escritorio de los agentes.

Ya estamos viendo cómo surge un nuevo ecosistema Copilot a medida que todos vosotros amplíais Copilot. Docenas de ISV han creado plug-ins de Copilot para sus aplicaciones, y los clientes también están creando sus propios plug-ins de línea de negocio para aumentar la productividad y crear conocimientos más profundos. No sólo puede acceder a ellos en Copilot, sino que también puede utilizarlos en todas nuestras aplicaciones.

IA & realidad mixta e IA & computación cuántica

Quiero terminar hablando de la innovación en dos áreas críticas: IA y realidad mixta, e IA y computación cuántica.

IA y realidad mixta

En primer lugar, la IA no se limita al lenguaje natural. Por supuesto, empieza con el lenguaje, pero va más allá. He aquí un atisbo de lo que es posible cuando el mundo real se convierte en tu indicador e interfaz.

Presta atención a cómo no sólo su voz, sino también sus gestos e incluso dónde mira, se convierten en la nueva entrada y lo transformador que puede ser para alguien como un trabajador que utiliza Dynamics 365:

IA y computación cuántica

La segunda área es la convergencia de la computación cuántica y la IA. La clave del descubrimiento científico actual es la simulación compleja de fenómenos naturales, ya sea química, biología o física, en la informática de alto rendimiento.

Se puede pensar en la IA como una emulación de esas simulaciones reduciendo esencialmente el espacio de búsqueda. Y eso es lo que estamos haciendo con Azure Quantum Elements. Al igual que los grandes modelos pueden generar texto, tu podrás generar compuestos químicos completamente nuevos.

Utilizando Quantum Elements, cualquier científico podrá diseñar nuevas moléculas con propiedades únicas para desarrollar productos químicos, fármacos, materiales avanzados o baterías más sostenibles.

Paralelamente, también estamos avanzando en computación cuántica, porque la cuántica será en última instancia el verdadero avance para acelerar todas estas simulaciones. De hecho, la semana pasada anunciamos una colaboración estratégica con Photonic para ampliar este enfoque cuántico de plataforma completa que hemos adoptado para las redes cuánticas.

Conclusión Keynote Satya Nadella en Microsoft Ignite

Al fin y al cabo, toda esta innovación sólo será útil si nos ayuda a todos en nuestras carreras, en nuestras comunidades, en nuestros países. Esa es nuestra misión. Queremos que cada persona y cada organización, en cada puesto y función empresarial, disponga de un Copilot.

Imagínate que 8.000 millones de personas tuvieran siempre acceso a un tutor personalizado, a un médico que les orientara médicamente o a un mentor que les aconsejara para cualquier cosa que necesitaran. Creo que todo eso está al alcance de la mano. Se trata de hacer posible lo imposible.

Para acabar quiero dejaros con un vídeo de Anton Mirhorodchenko, un desarrollador de Ucrania, que comparte la historia de cómo Copilot le ha empoderado:

Esta información está basada en la publicación de Satya Nadella (Chairman y CEO de Microsoft) en LinkedIn: The age of copilots que a su vez es un extracto de su keynote en Microsoft Ignite. Otras fuentes de información referenciadas: Azure Boost, Azure Cobalt, With a systems approach to chips, Microsoft aims to tailor everything ‘from silicon to service’ to meet AI demand, Azure announces new AI optimized VM series featuring AMD’s flagship MI300X GPU, Microsoft Azure delivers purpose-built cloud infrastructure in the era of AI, Top10 super computers november 2023 (Top500), New innovations in confidential computing from Azure at Ignite 2023, Phi 2, Azure AI Studio, Fabric Mirroring, Microsoft Mesh, Copilot as a Service, Azure Quantum Elements y Strategic Collaboration with Photonic.