6ª edición del informe CyberSignals de Microsoft

Microsoft acaba de lanzar la sexta edición de CyberSignals, el informe de inteligencia que analiza las últimas amenazas de seguridad cibernética.

En esta ocasión, se destaca el gran impacto de la IA en el panorama de la ciberseguridad, con nueva información sobre medidas para proteger las plataformas de IA contra los intentos de ataque.

Los ciberdelincuentes y la IA

Los ciberdelincuentes recurren a la IA, incluidos los LLM, para mejorar su eficacia y aprovechar plataformas que puedan favorecer sus objetivos y técnicas de ataque. Aunque los motivos y la sofisticación de los actores de las amenazas varían, comparten estrategias comunes a la hora de desplegar ataques. Entre ellas se incluyen el estudio de las industrias, ubicaciones y relaciones de las víctimas potenciales; la creación de código, incluida la mejora de los scripts de software y el desarrollo de malware; y la asistencia en el aprendizaje y el uso de lenguajes tanto humano como de programación. La investigación de Microsoft con OpenAI no ha identificado ataques significativos que empleen los LLM que vigilan de cerca.

Microsoft utiliza varios métodos para protegerse de este tipo de ciberamenazas, como la detección de amenazas mediante IA para identificar cambios en el uso de los recursos o el tráfico de la red; el análisis de comportamiento para hallar inicios de sesión de riesgo y comportamientos anómalos; modelos de machine learning para detectar inicios de sesión de riesgo y malware; Zero Trust, donde cada solicitud de acceso debe estar totalmente autenticada, autorizada y cifrada; y la verificación del estado de los dispositivos antes de que puedan conectarse a la red corporativa.

Informe Cyber Signals

Hoy en día, el mundo de la ciberseguridad está experimentando una transformación increíble. La inteligencia artificial (IA) está a la vanguardia de este cambio, planteando tanto una amenaza como una oportunidad. Mientras que la IA tiene el potencial de permitir a las organizaciones derrotar ciberataques a la velocidad de la máquina e impulsar la innovación y la eficiencia en la detección de amenazas, la caza y la respuesta a incidentes, los adversarios pueden utilizar la IA como parte de sus hazañas. Nunca ha sido tan importante diseñar, desplegar y utilizar la IA de forma segura.

En Microsoft, están explorando el potencial de la IA para mejorar sus medidas de seguridad, desbloquear protecciones nuevas y avanzadas y crear mejor software. Con la IA, tienen el poder de adaptarnos a la evolución de las amenazas, detectar anomalías al instante, responder rápidamente para neutralizar los riesgos y adaptar las defensas a las necesidades de una organización.

La IA también puede ayudarnos a superar otro de los mayores retos del sector. Ante la escasez de mano de obra en ciberseguridad en todo el mundo, donde se necesitan unos 4 millones de profesionales, la IA tiene el potencial de ser una herramienta fundamental para cerrar la brecha de talento y ayudar a los defensores a ser más productivos.

Ya hemos visto en un estudio cómo Copilot for Security puede ayudar a los analistas de seguridad independientemente de su nivel de experiencia: en todas las tareas, los participantes fueron un 44% más precisos y un 26% más rápidos.

A medida que buscamos asegurar el futuro, debemos asegurarnos de que equilibramos la preparación segura para la IA y el aprovechamiento de sus beneficios, porque la IA tiene el poder de elevar el potencial humano y resolver algunos de nuestros desafíos más graves.

Un futuro más seguro con IA requerirá avances fundamentales en ingeniería de software.

Requerirá que comprendamos y contrarrestemos las amenazas impulsadas por la IA como componentes esenciales de cualquier estrategia de seguridad.

Esta información publicación de Microsoft y OpenAI detalla los intentos de los ciberdelincuentes en probar y explorar la utilidad de los grandes modelos de lenguaje (LLM) en las técnicas de ataque.

¿Cuál es la situación actual?

Las herramientas tradicionales ya no están a la altura de las amenazas que plantean los ciberdelincuentes. La velocidad, escala y sofisticación crecientes de los ciberataques recientes exigen un nuevo enfoque de la seguridad.

Además, dada la escasez de mano de obra especializada en ciberseguridad y el aumento de la frecuencia y gravedad de las ciberamenazas, es urgente colmar esta laguna de competencias.

La IA puede inclinar la balanza para los defensores. Un estudio reciente de Microsoft Copilot for Security (actualmente en fase de pruebas preliminares para clientes) mostró un aumento de la velocidad y la precisión de los analistas de seguridad, independientemente de su nivel de experiencia, en tareas comunes como la identificación de scripts utilizados por los atacantes, la creación de informes de incidentes y la identificación de los pasos de corrección adecuados.

- El 44% era más preciso en todas las tareas al usar Copilot for Security

- El 90% dijo que querría Copilot la próxima vez que realicen la misma tarea

- El 26% fue más rápido en todas las tareas al usar Copilot for Security

Los atacantes exploran las tecnologías de IA

El panorama de las ciberamenazas se ha vuelto cada vez más desafiante, con atacantes cada vez más motivados, más sofisticados y con mejores recursos. Tanto los actores de las amenazas como los defensores están buscando la IA, incluidos los LLM, para mejorar su productividad y aprovechar las plataformas accesibles que podrían adaptarse a sus objetivos y técnicas de ataque.

Dada la rápida evolución del panorama de las amenazas, Microsft anuncia los principios que guían sus acciones para mitigar el riesgo de que los actores de amenazas, incluidas las amenazas persistentes avanzadas (advanced persistent threats · APT), los manipuladores persistentes avanzados (advanced persistent manipulators · APM) y los sindicatos de ciberdelincuentes, que usan plataformas y APIs de IA. Estos principios incluyen la identificación y actuación contra el uso de IA por parte de actores de amenazas maliciosas, la notificación a otros proveedores de servicios de IA, la colaboración con otras partes interesadas y la transparencia.

Aunque los motivos y la sofisticación de los actores de amenazas varían, comparten tareas comunes a la hora de desplegar ataques. Entre ellas se incluyen el reconocimiento, como la investigación de las industrias, ubicaciones y relaciones de las víctimas potenciales; la codificación, incluida la mejora de los scripts de software y el desarrollo de malware; y la asistencia en el aprendizaje y el uso de lenguajes tanto humanos como automáticos.

Los estados-nación intentan aprovechar la IA

En colaboración con OpenAI, Microsft está compartiendo información sobre amenazas que muestra la detección de adversarios afiliados a estados -rastreados como Forest Blizzard, Emerald Sleet, Crimson Sandstorm, Charcoal Typhoon y Salmon Typhoon- que utilizan LLM para aumentar las ciberoperaciones.

El objetivo de la asociación de investigación de Microsoft con OpenAI es garantizar el uso seguro y responsable de tecnologías de IA como ChatGPT, manteniendo los más altos estándares de aplicación ética para proteger a la comunidad de posibles usos indebidos.

Forest Blizzard (STRONTIUM)

Forest Blizzard (STRONTIUM), un eficaz actor de la inteligencia militar rusa vinculado a la Dirección Principal del Estado Mayor de las Fuerzas Armadas de Rusia o GRU Unidad 26165, se ha dirigido a víctimas de interés táctico y estratégico para el gobierno ruso.

Sus actividades abarcan diversos sectores, como defensa, transporte/logística, gobierno, energía, ONG y tecnologías de la información.

Emerald Sleet (Velvet Chollima)

Emerald Sleet (Velvet Chollima) es un actor de amenazas norcoreano que Microsoft ha descubierto haciéndose pasar por instituciones académicas y ONG de renombre para atraer a las víctimas y hacer que respondan con opiniones y comentarios de expertos sobre políticas exteriores relacionadas con Corea del Norte.

El uso que Emerald Sleet hacía de los LLM implicaba la investigación de think tanks y expertos en Corea del Norte, así como la generación de contenidos susceptibles de ser utilizados en campañas de spear phishing. Emerald Sleet también interactuó con los LLM para conocer las vulnerabilidades de dominio público, solucionar problemas técnicos y obtener ayuda sobre el uso de diversas tecnologías web.

Crimson Sandstorm (CURIUM

Crimson Sandstorm (CURIUM) es un actor de amenazas iraní que, según las evaluaciones, está relacionado con el Cuerpo de la Guardia Revolucionaria Islámica. El uso de LLM ha implicado solicitudes de apoyo en torno a la ingeniería social, asistencia en la solución de errores, desarrollo .NET y formas en que un atacante podría evadir la detección cuando se encuentra en una máquina comprometida.

Charcoal Typhoon (CHROMIUM)

Charcoal Typhoon (CHROMIUM) es un actor de amenazas afiliado a China que se centra principalmente en el seguimiento de grupos en Taiwán, Tailandia y Mongolia, Malasia, Francia, Nepal y personas de todo el mundo que se oponen a las políticas de China. En operaciones recientes, se ha observado que Charcoal Typhoon ha recurrido a LLM para obtener información sobre investigaciones destinadas a comprender tecnologías, plataformas y vulnerabilidades específicas, lo que indica que se encuentran en las fases preliminares de recopilación de información.

Salmon Typhoon

Otro grupo apoyado por China, Salmon Typhoon, ha estado evaluando la eficacia de utilizar LLM a lo largo de 2023 para obtener información sobre temas potencialmente delicados, personas de alto perfil, geopolítica regional, influencia estadounidense y asuntos internos. Este compromiso tentativo con los LLM podría reflejar tanto una ampliación de sus herramientas de recopilación de inteligencia como una fase experimental de evaluación de las capacidades de las tecnologías emergentes.

La investigación de Microsoft con OpenAI no ha identificado ataques significativos que empleen los LLM que vigilan de cerca.

Se han tomado medidas para desarticular los activos y cuentas asociadas con estas

amenazas y crear protecciones y mecanismos de seguridad en torno a los modelos de MIcrosoft y OpenAI.

Surgen otras amenazas de IA

El fraude impulsado por la IA es otra preocupación crítica. La síntesis de voz es un ejemplo de ello, donde una muestra de voz de tres segundos puede entrenar a un modelo para que suene como cualquiera. Incluso algo tan inocuo como el saludo del buzón de voz puede utilizarse para obtener una muestra suficiente.

Gran parte de la forma en que interactuamos y hacemos negocios depende de la prueba de identidad, como el reconocimiento de la voz, la cara, la dirección de correo electrónico o el estilo de escritura de una persona.

Es crucial que entendamos cómo los actores maliciosos utilizan la IA para socavar los antiguos sistemas de comprobación de identidad, de modo que podamos abordar casos complejos de fraude y otras amenazas emergentes de ingeniería social que ocultan identidades.

La IA también puede utilizarse para ayudar a las empresas a impedir intentos de fraude. Aunque Microsoft interrumpió su relación con una empresa de Brasil, sus sistemas de IA detectaron los intentos de reconstituirse para volver a entrar en el ecosistema.

El grupo intentó continuamente ofuscar su información, ocultar sus raíces de propiedad y volver a entrar, pero las detecciones de IA de Microsoft utilizaron casi una docena de señales de riesgo para señalar a la empresa fraudulenta y asociarla con comportamientos sospechosos previamente reconocidos, bloqueando así sus intentos.

Microsoft está comprometida con una IA responsable dirigida por humanos que ofrezca privacidad y seguridad con humanos que proporcionen supervisión, evalúen recursos e interpreten políticas y normativas.

Educa a los empleados y al público sobre los ciberriesgos

- Utiliza políticas de acceso condicional: Estas políticas proporcionan una orientación clara y autodesplegable para reforzar tu postura de seguridad que protegerá automáticamente a los tenants en función de las señales de riesgo, las licencias y el uso. Las políticas de acceso condicional son personalizables y se adaptan al cambiante panorama de las ciberamenazas.

- Forma y recicla a los empleados en tácticas de ingeniería social: Educa a los empleados y al público para que reconozcan y reaccionen ante los ataques de ingeniería social de phishing por correo electrónico, vishing (correo de voz), smishing (SMS/texto) y aplica las mejores prácticas de seguridad para Microsoft Teams.

- Proteger rigurosamente los datos: Asegúrate de que los datos permanezcan privados y controlados de extremo a extremo.

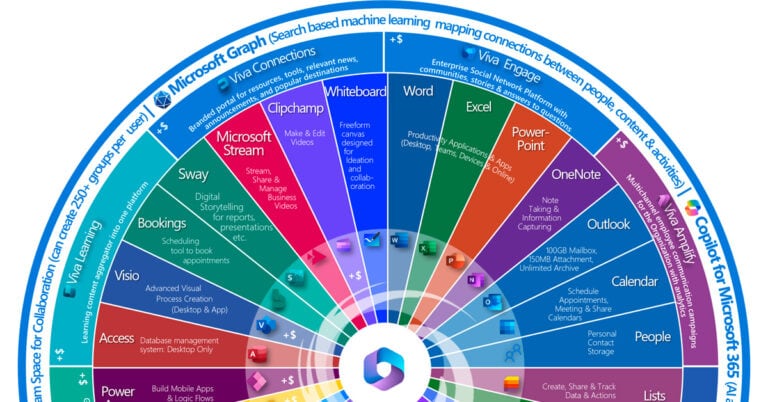

- Aprovecha las herramientas de seguridad de IA generativa: Herramientas como Microsoft Copilot for Security pueden ampliar las capacidades y mejorar la postura de seguridad de la organización.

- Habilita la autenticación multifactor: Habilita la autenticación multifactor para todos los usuarios, especialmente para las funciones de administrador, ya que reduce el riesgo de apropiación de cuentas en más del 99%.

Defensa ante ataques

Microsoft detecta una enorme cantidad de tráfico malicioso: más de 65 billones de señales de ciberseguridad al día. La IA está impulsando su capacidad para analizar esta información y garantizar que las ideas más valiosas salgan a la luz para ayudar a detener las amenazas. También utilizan esta inteligencia de señales para potenciar la IA Generativa para la protección avanzada frente a amenazas, la seguridad de datos y la seguridad de identidades, con el fin de ayudar a los defensores a detectar lo que otros pasan por alto.

Microsoft utiliza varios métodos para protegerse a sí misma y a sus clientes de las ciberamenazas, como la detección de amenazas basada en IA para detectar cambios en el uso de los recursos o el tráfico de la red; análisis de comportamiento para detectar inicios de sesión peligrosos y comportamientos anómalos; modelos de aprendizaje automático (ML) para detectar inicios de sesión peligrosos y malware; modelos de confianza cero en los que cada solicitud de acceso debe estar totalmente autenticada, autorizada y cifrada; y verificación del estado de los dispositivos antes de que puedan conectarse a una red corporativa.

Naturalmente, Microsoft crea modelos de IA para detectar estos ataques a Microsoft y sus clientes. Detectan cuentas falsas de estudiantes y escuelas, empresas u organizaciones falsas que han alterado sus datos firmográficos u ocultado sus verdaderas identidades para evadir sanciones, eludir controles u ocultar transgresiones delictivas pasadas como condenas por corrupción, intentos de robo, etc.

El uso de GitHub Copilot, Microsoft Copilot for Security y otras funciones de chat copilot integradas en nuestra infraestructura interna de ingeniería y operaciones puede ayudar a prevenir incidentes que podrían afectar a las operaciones.

Para hacer frente a las amenazas del correo electrónico, Microsoft está mejorando las capacidades para recoger señales además de la composición de un correo electrónico para entender si es malicioso. Con la inteligencia artificial en manos de los autores de las amenazas, se ha producido una afluencia de correos electrónicos perfectamente escritos que mejoran los errores lingüísticos y gramaticales obvios que a menudo revelan los intentos de phishing, lo que hace que estos intentos sean más difíciles de detectar.

Se necesitan campañas continuas de formación de los empleados y de concienciación pública para ayudar a combatir la ingeniería social, que es la única palanca que depende al 100% del error humano. La historia nos ha enseñado que las campañas eficaces de concienciación pública sirven para cambiar comportamientos.

Microsoft anticipa que la IA evolucionará las tácticas de ingeniería social, creando ataques más sofisticados, incluyendo deepfakes y clonación de voz, particularmente si los atacantes encuentran tecnologías de IA que operan sin prácticas responsables y controles de seguridad incorporados.

La prevención es clave para combatir todas las ciberamenazas, ya sean tradicionales o basadas en IA.

Recomendaciones

- Aplica controles de IA del proveedor y evalúa continuamente su adecuación: Para cualquier IA introducida en tu empresa, busca las características integradas de los respectivos proveedores para delimitar el acceso a la IA a los empleados y equipos que utilizan la tecnología para fomentar la adopción segura y conforme de la IA. Reúne a las partes interesadas en el riesgo cibernético de toda la organización para alinearse con los casos de uso definidos de los empleados de IA y los controles de acceso.

Los responsables de riesgos y los CISO deben determinar periódicamente si los casos de uso y las políticas son adecuados, o si deben cambiar a medida que evolucionan los objetivos y los conocimientos. - Proteger contra inyecciones rápidas: Aplica una estricta validación de entradas para las solicitudes proporcionadas por el usuario. Utilizar un filtrado y una codificación de salida que tengan en cuenta el contexto para evitar la manipulación de las instrucciones. Actualiza y ajusta periódicamente los LLM para mejorar su comprensión de las entradas maliciosas y los casos extremos. Supervisa y registra las interacciones de los LLM para detectar y analizar posibles intentos de inyección de avisos.

- Exige transparencia en toda la cadena de suministro de IA: A través de prácticas claras y abiertas, evalúa todas las áreas en las que la IA puede entrar en contacto con los datos de tu organización, incluso a través de socios y proveedores externos. Utiliza las relaciones con los socios y los equipos multifuncionales de ciberriesgo para explorar los aprendizajes y cerrar las brechas resultantes. Mantener los programas actuales de Cero Confianza (Zero Trust) y gobernanza de datos es más importante que nunca en la era de la IA.

- Manténte centrado en las comunicaciones: Los líderes de ciberriesgo deben reconocer que los empleados son testigos del impacto y los beneficios de la IA en sus vidas personales y, naturalmente, querrán explorar la aplicación de tecnologías similares en entornos de trabajo híbridos.

Los CISO y otros líderes que gestionan el ciberriesgo pueden compartir y ampliar proactivamente las políticas de sus organizaciones sobre el uso y los riesgos de la IA, incluidas las herramientas de IA designadas que están aprobadas para la empresa y los puntos de contacto para el acceso y la información. Las comunicaciones proactivas ayudan a mantener a los empleados informados y capacitados, al tiempo que reducen el riesgo de que la IA no gestionada entre en contacto con los activos informáticos de la empresa.

Esta información está basada en «Cyber Signals: Gestionar las ciberamenazas y reforzar las defensas en la era de la IA» publicado en la zona de prensa de Microsoft, la publicación de Solange Cummins (Senior Communications Manager at Microsoft Ibérica) en LinkedIn y el documento PDF Cyber Signals February 2024 – Navigating cyberthreats and strengthening defenses in the era of AI.